5. Calcolare l'accuratezza

Oltre al tasso di errore dei caratteri, è possibile calcolare l'accuratezza di un modello di riconoscimento del testo su nuove pagine. È un test utile prima di eseguire un modello su un intero documento o raccolta.

Fase precedente: Tasso di errore del carattere e curva di apprendimento

Questa funzione non è attualmente supportata da Transkribus. Nel frattempo, è possibile utilizzarlo all'interno di Transkribus eXpert.

Transkribus eXpert (deprecato)

È possibile misurare l'accuratezza del modello su pagine specifiche con la funzione "Calcolo dell'accuratezza" nella scheda "Strumenti".

Per farlo, sono necessarie due versioni della trascrizione: la Ground Truth (cioè la trascrizione manuale più vicina possibile al testo originale) e la trascrizione generata dal modello di Text Recognition.

Per ottenere il valore più significativo dalla misurazione dell'accuratezza, sarebbe meglio utilizzare pagine che non sono state utilizzate durante il processo di addestramento e che quindi sono nuove per il modello. Anche l'utilizzo delle pagine del set di convalida è un'opzione, ma non è l'ideale come le pagine completamente nuove. L'utilizzo di pagine dal Training Set non è una buona idea, perché in questo modo si ottengono valori CER inferiori a quelli reali.

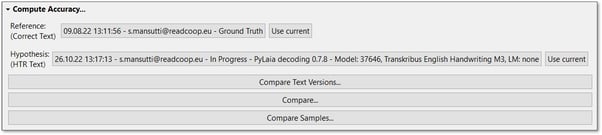

Per effettuare il confronto, è necessario selezionare due versioni di trascrizione della stessa pagina. Scegliere come "Reference" la versione della pagina Ground Truth e come "Hypothesis" la versione che è stata generata automaticamente con il modello Text Recognition e sulla quale si desidera verificare la bontà del risultato.

È possibile modificare le versioni da confrontare facendo clic sul pulsante grigio accanto a "Riferimento" e "Ipotesi". Fare doppio clic per scegliere la versione desiderata del documento nella finestra visualizzata. Le versioni selezionabili per "Riferimento" e "Ipotesi" sono versioni diverse del documento, create dopo l'esecuzione di un nuovo lavoro o il salvataggio delle trascrizioni.

Ci sono tre opzioni di confronto disponibili:

- Confronta le versioni del testo:

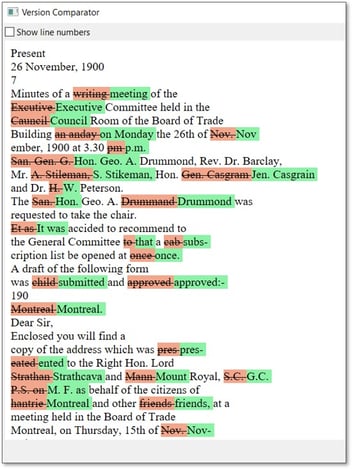

Questa funzione offre una rappresentazione visiva di ciò che il modello HTR ha trascritto in modo corretto e scorretto.

Dopo aver selezionato le versioni di riferimento e di ipotesi, fare clic su "Confronta versioni di testo...". Le parole segnate in rosso sono quelle trascritte in modo errato dal modello di riconoscimento del testo; in verde, le parole sono mostrate come scritte nella trascrizione di Ground Truth. Si noti che anche se un solo carattere è sbagliato, l'intera parola è contrassegnata in rosso. Nei passaggi senza colore, il testo riconosciuto è identico alla Ground Truth.

- Confronta e misura il CER:

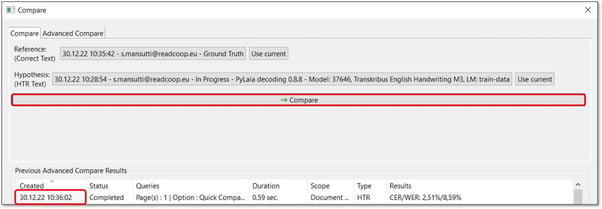

Questo controllo di accuratezza consente di confrontare le due versioni di una stessa pagina e di misurare il tasso di errore di scrittura (CER) e il tasso di errore di parola (WER) di quella pagina.

Per accedervi, fare clic su "Confronta...". Innanzitutto, assicuratevi che siano state selezionate le versioni giuste come Riferimento e Ipotesi nella sezione superiore della finestra che appare. Quindi premere il pulsante "Confronta". Il risultato verrà visualizzato nella parte inferiore della finestra dopo alcuni secondi.

I valori sono calcolati per la pagina attualmente caricata in background. Nell'immagine qui sopra, abbiamo un CER del 2,51% su quella pagina, il che significa che il 97,49% dei caratteri nella trascrizione automatica sono corretti.

Facendo doppio clic sulla data e l'ora nella colonna "Creato" della scheda di confronto semplice, si accede automaticamente alla finestra "Statistiche avanzate". Qui si ottengono indicazioni e valori più dettagliati e i risultati possono essere esportati in un file Excel.

Le tabelle e il grafico mostrano l'accuratezza del modello di riconoscimento del testo in quella pagina in termini di tasso di errore di parola e tasso di errore di carattere. Facendo doppio clic sulla riga con il numero di pagina, si arriva al confronto del testo, dove è possibile verificare quali parole o passaggi di testo sono stati contestati.

Se si desidera verificare l'accuratezza di più pagine contemporaneamente, all'apertura della finestra "Confronta" è possibile scegliere la scheda "Confronto avanzato" a destra. Aggiungere le pagine che si desidera valutare (ad esempio, 1-6), oppure fare clic sul pulsante con i tre punti all'estrema destra per scegliere le singole pagine.

Dopo aver avviato il controllo dell'accuratezza facendo clic su "Confronta", i risultati saranno mostrati nella tabella sottostante e facendo doppio clic sulla cella della data e dell'ora nella colonna "Creato", si arriverà nuovamente alla finestra "Statistiche avanzate".

La visualizzazione della panoramica mostra due tabelle: una con il valore "Overall", che è il valore medio del riconoscimento su tutte le pagine calcolate del documento. Nella tabella seguente sono riportati i valori delle singole pagine. In questo modo, è possibile confrontare i risultati su pagine diverse e, facendo doppio clic sulla riga, si arriva al confronto del testo, dove è possibile verificare quali parole o passaggi di testo sono stati messi in discussione. Nota: la ponderazione delle pagine per il valore "Overall" è calcolata in base al numero di parole riconosciute in una pagina.

- confronta campioni

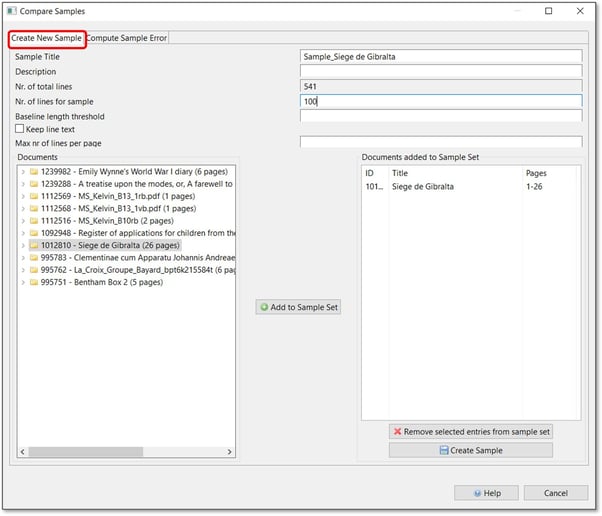

La funzionalità "Confronta campioni" è utile se si sta pianificando un progetto di riconoscimento più ampio e si desidera valutare quale modello scegliere prima di eseguirlo sull'intero documento. Questa funzione di confronto sceglie righe casuali dal documento di esempio e testa le prestazioni del modello su queste righe.

Ha senso mettere da parte alcune pagine all'inizio per usarle come documento di esempio. Questo è vantaggioso, in quanto il materiale su cui verrà testato il modello non è mai stato visto prima e quindi il risultato della valutazione sarà più affidabile.

La funzionalità "Confronta campioni" si trova all'interno della scheda "Strumenti" nella sezione "Calcolo della precisione". Per aprirla, fare clic su "Confronta campioni" e, alla voce "Crea nuovi campioni", compilare le informazioni richieste.

In "Numero di linee per il campione", è possibile definire il numero di linee che si desidera testare. 500 è la media consigliata. Più righe si mettono qui, minore sarà la variazione del risultato e la prognosi sarà più precisa. Per un progetto di grandi dimensioni con molte pagine, potrebbe essere ragionevole dire 1000 righe; per un tentativo molto piccolo, forse 100 righe sono già sufficienti. Anche in questo caso, il modo migliore per procedere è un approccio "per tentativi", poiché dipende sempre dall'obiettivo individuale.

Con la "Soglia di lunghezza della linea di base" è possibile controllare la lunghezza delle linee, il che è pratico se nel materiale sono presenti molte linee corte, come spesso accade, ad esempio, con tabelle e giornali. Il valore da inserire deve essere compreso tra 0 e 1 (ad esempio, 0,5 per la metà della larghezza della pagina). Se impostato, le linee di base con una lunghezza inferiore a questa frazione della larghezza della pagina verranno scartate. Per il materiale scritto a mano con una sola colonna, questo passaggio probabilmente non è necessario.

Facendo clic sull'opzione "Mantieni il testo della riga", è possibile mantenere il testo già presente nei documenti e correggere le righe solo dopo aver creato il campione.

Dall'elenco a sinistra, scegliere i documenti di cui deve essere composto il campione tramite il pulsante "Aggiungi al set di campioni". Quindi fare clic su "Crea campione". Transkribus sceglierà ora in modo casuale il numero definito di righe nei documenti selezionati.

Il passo successivo consiste nell'aprire il documento di esempio (che potete trovare nella vostra raccolta) e trascrivere manualmente i frammenti di riga (se non avete conservato il testo come descritto sopra). Si tratta di una sola riga per pagina e quindi la trascrizione nella maggior parte dei casi sarà rapida. Se avete finito una riga, passate alla pagina successiva del documento di esempio per procedere.

Una volta terminata la trascrizione, eseguire il modello che si desidera testare sul documento campione per produrre la trascrizione.

Potete quindi confrontare le due versioni. A tal fine, aprire la scheda "Compute Sample Error" nella finestra "Compare Samples" e scegliere il campione che si desidera valutare. Quindi fare clic su "Compute" per avviare il lavoro. Non appena appare "Completato" nella colonna "Stato", è possibile fare doppio clic sulla cella della colonna "Creato" per visualizzare i risultati.

Facendo doppio clic sulla data e l'ora nella colonna "Creato" della tabella "CER per pagina campione", si accede automaticamente alla finestra "Statistiche avanzate" e si osservano le misure di precisione in modo più dettagliato.