5. Genauigkeit berechnen

Zusätzlich zur Zeichenfehlerrate ist es möglich, die Genauigkeit eines Texterkennungsmodells auf neuen Seiten zu berechnen. Dies ist ein nützlicher Test, bevor ein Modell für ein ganzes Dokument oder eine ganze Sammlung ausgeführt wird

Vorheriger Schritt: Charakterfehlerrate und Lernkurve

Diese Funktion wird in Transkribus derzeit nicht unterstützt. In der Zwischenzeit können Sie es in Transkribus eXpert verwenden.

Transkribus eXpert (veraltet)

Sie können die Genauigkeit Ihres Modells auf bestimmten Seiten mit der Funktion „Rechengenauigkeit“ auf der Registerkarte „Tools“ messen.

Dazu benötigen Sie zunächst zwei Versionen der Transkription: die Ground Truth (d. h. die manuelle Transkription so nah wie möglich am Originaltext) und das vom Texterkennungsmodell generierte Transkript.

Um den wichtigsten Wert aus der Genauigkeitsmessung zu erhalten, ist es am besten, Seiten zu verwenden, die während des Trainingsprozesses nicht verwendet wurden und daher neu für das Modell sind. Die Verwendung von Seiten aus dem Validation Set ist ebenfalls eine Option, aber nicht so ideal wie komplett neue Seiten. Die Verwendung von Seiten aus dem Trainingsset ist keine gute Idee, da dadurch CER-Werte ausgegeben werden, die niedriger sind, als sie tatsächlich sind.

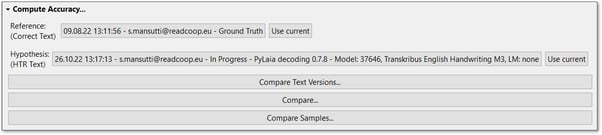

Für den Vergleich müssen Sie zwei Transkriptionsversionen derselben Seite auswählen. Wählen Sie als "Referenz" die Version der Ground Truth-Seite und als "Hypothese" die Version, die automatisch mit dem Texterkennungsmodell generiert wurde und an der Sie testen möchten, wie gut das Ergebnis ist.

Sie können die zu vergleichenden Versionen ändern, indem Sie auf die graue Schaltfläche neben „Referenz“ und „Hypothese“ klicken. Doppelklicken Sie, um die gewünschte Version des Dokuments im angezeigten Fenster auszuwählen. Die Versionen, die für "Referenz" und "Hypothese" ausgewählt werden können, sind verschiedene Versionen Ihres Dokuments, die nach dem Ausführen eines neuen Auftrags oder dem Speichern von Transkriptionen erstellt wurden.

Es stehen drei Vergleichsoptionen zur Verfügung:

- Textversionen vergleichen:

Mit dieser Funktion erhalten Sie eine visuelle Darstellung dessen, was das HTR-Modell korrekt und falsch transkribiert hat.< br > Klicken Sie nach der Auswahl der Referenz- und Hypothesenversion auf „Textversionen vergleichen…“. Die rot markierten Wörter sind diejenigen, die vom Texterkennungsmodell falsch transkribiert wurden. In grün werden die Wörter als in der Ground Truth-Transkription geschrieben angezeigt. Bitte beachten Sie, dass selbst wenn nur ein Zeichen falsch ist, das ganze Wort rot markiert ist. In den Passagen ohne Farbe ist der erkannte Text identisch mit der Ground Truth.

< br >< em>

- Vergleichen und messen Sie die Cer :

Mit dieser Genauigkeitsprüfung können Sie die beiden Versionen derselben Seite vergleichen und die Chacareter-Fehlerrate (Cer) und die Wortfehlerrate (WER) auf dieser Seite messen.

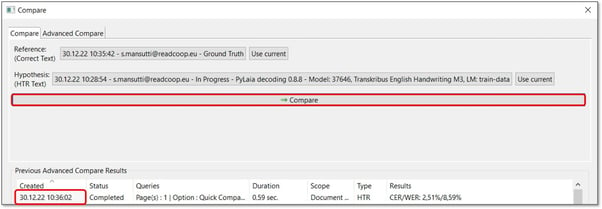

Um darauf zuzugreifen, klicken Sie auf "Vergleichen...". Stellen Sie zunächst sicher, dass im oberen Bereich des erscheinenden Fensters die richtigen Versionen als Referenz und Hypothese ausgewählt wurden. Klicken Sie dann auf die Schaltfläche „Vergleichen“. Das Ergebnis wird nach einigen Sekunden im unteren Bereich des Fensters angezeigt.

Die Werte werden für die Seite berechnet, die Sie derzeit im Hintergrund geladen haben. Im obigen Bild haben wir auf dieser Seite eine Cer von 2,51 %, was bedeutet, dass 97,49 % der Zeichen in der automatisierten Abschrift korrekt sind.

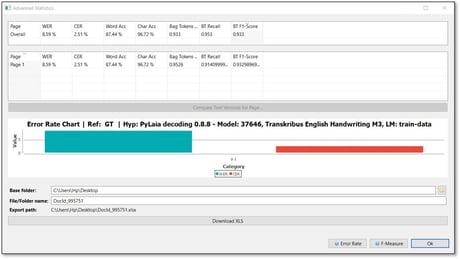

Durch Doppelklicken auf das Datum und die Uhrzeit in der Spalte „Erstellt“ auf der Registerkarte „Einfacher Vergleich“ gelangen Sie automatisch zum Fenster „Erweiterte Statistik“. Hier erhalten Sie detailliertere Angaben und Werte, und die Ergebnisse können in eine Excel-Datei exportiert werden. < br >

< em>

Die Tabellen und das Diagramm zeigen die Genauigkeit des Texterkennungsmodells auf dieser Seite in Bezug auf die Wortfehlerrate und die Zeichenfehlerrate an. Durch Doppelklick auf die Zeile mit der Seitenzahl gelangen Sie zum Textvergleich, in dem Sie überprüfen können, welche Wörter oder Textpassagen herausfordernd waren.

Wenn Sie die Genauigkeit für mehrere Seiten gleichzeitig überprüfen möchten, können Sie beim Öffnen des Fensters "Vergleichen" die Registerkarte "Erweitertes Vergleichen" auf der rechten Seite wählen. Fügen Sie die Seiten hinzu, die Sie auswerten möchten (z. B. 1-6), oder klicken Sie auf die Schaltfläche mit den drei Punkten ganz rechts, um einzelne Seiten auszuwählen.

Nachdem Sie die Genauigkeitsprüfung durch Klicken auf "Vergleichen" gestartet haben, werden die Ergebnisse in der folgenden Tabelle angezeigt und durch Doppelklick auf die Datums- und Zeitzelle in der Spalte "Erstellt" gelangen Sie wieder zum Fenster "Erweiterte Statistik". Die Übersichtsanzeige zeigt zwei Tabellen: eine mit dem Wert „Gesamt“, der der Durchschnittswert der Erkennung auf allen berechneten Seiten im Dokument ist. In der folgenden Tabelle finden Sie die Werte für die einzelnen Seiten. Auf diese Weise können Sie die Ergebnisse auf verschiedenen Seiten vergleichen, und durch Doppelklicken auf die Zeile gelangen Sie zum Textvergleich, in dem Sie überprüfen können, welche Wörter oder Textpassagen herausfordernd waren. Hinweis: Die Gewichtung der Seiten für den Wert „Gesamt“ wird basierend auf der Anzahl der erkannten Wörter auf einer Seite berechnet.

- ompare Samples

Die Funktion "Samples vergleichen" ist nützlich, wenn Sie ein größeres Erkennungsprojekt planen und auswerten möchten, welches Modell Sie wählen sollten, bevor Sie es für das gesamte Dokument ausführen. Diese Vergleichsfunktion wählt zufällige Zeilen aus dem Beispieldokument aus und testet die Leistung des Modells auf diesen Zeilen.

Es ist sinnvoll, einige Seiten am Anfang beiseite zu legen, um sie als Beispieldokument zu verwenden. Dies ist von Vorteil, da das Material, an dem das Modell getestet wird, noch nie zuvor gesehen wurde und das Bewertungsergebnis daher zuverlässiger ist.

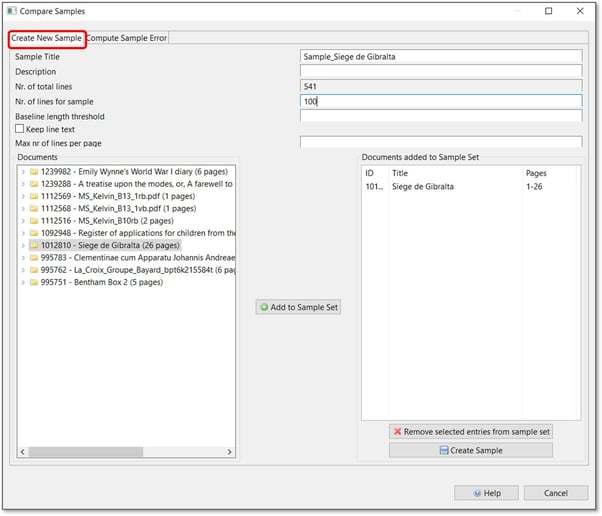

Die Funktion „Proben vergleichen“ befindet sich auf der Registerkarte „Tools“ im Abschnitt „Rechengenauigkeit“. Um es zu öffnen, klicke auf „Muster vergleichen“ und fülle unter „Neue Muster erstellen“ die erforderlichen Informationen aus.

Bei "Anzahl der Zeilen für die Probe" können Sie definieren, wie viele Zeilen Sie testen möchten. 500 ist der empfohlene Durchschnitt. Je mehr Zeilen Sie hier einfügen, desto geringer ist die Variation im Ergebnis, und die Prognose ist präziser. Für ein großes Projekt mit vielen Seiten könnte es sinnvoll sein, 1000 Zeilen zu sagen; für einen sehr kleinen Versuch reichen vielleicht bereits 100 Zeilen aus. Auch hier geht es am besten mit einem „Trial and Error“ -Ansatz, da es immer vom individuellen Ziel abhängt.

Mit dem „Basislängen-Schwellenwert“ können Sie die Länge von Linien steuern, was praktisch ist, wenn Sie viele kurze Linien in Ihrem Material haben, was z. B. bei Tischen und Zeitungen häufig der Fall ist. Der einzugebende Wert sollte zwischen 0 und 1 liegen (z. B. 0,5 für die halbe Seitenbreite). Wenn diese Option aktiviert ist, werden Grundlinien mit einer Länge, die kleiner als dieser Bruchteil der Seitenbreite ist, verworfen. Für handschriftliches Material mit nur einer Spalte ist dieser Schritt wahrscheinlich nicht erforderlich.

Wenn Sie auf die Option „Zeilentext beibehalten“ klicken, können Sie den Text, den Sie bereits in Ihren Dokumenten haben, buchstäblich beibehalten und müssen die Zeilen erst nach dem Erstellen des Beispiels korrigieren.

Wählen Sie aus der Liste auf der linken Seite die Dokumente aus, aus denen die Probe bestehen soll, indem Sie auf die Schaltfläche „Zum Probensatz hinzufügen“ klicken. Klicken Sie dann auf „Muster anlegen“. Transkribus wählt nun zufällig die definierte Anzahl von Zeilen in den ausgewählten Dokumenten aus.

Der nächste Schritt besteht darin, das Beispieldokument zu öffnen (Sie finden es in Ihrer Sammlung) und die Zeilenausschnitte manuell zu transkribieren (wenn Sie den Text nicht wie oben beschrieben beibehalten haben). Es wird nur eine Zeile pro Seite sein, und daher wird das Transkribieren in den meisten Fällen schnell gehen. Wenn Sie eine Zeile beendet haben, springen Sie zur nächsten Seite des Beispieldokuments, um fortzufahren.

Wenn Sie mit der Transkription fertig sind, führen Sie das Modell aus, das Sie auf dem Beispieldokument testen möchten, um die Transkription zu erstellen.

Sie können dann die beiden Versionen vergleichen. Öffnen Sie dazu die Registerkarte „Compute Sample Error“ (Rechenprobenfehler) im Fenster „Compare Samples“ (Proben vergleichen) und wählen Sie die Probe aus, die Sie bewerten möchten. Klicken Sie dann auf "Compute", um den Job zu starten. Sobald "Abgeschlossen" in der Spalte "Status" angezeigt wird, können Sie auf die Zelle in der Spalte "Erstellt" doppelklicken, um die Ergebnisse anzuzeigen.

Durch Doppelklicken auf das Datum und die Uhrzeit in der Spalte „Erstellt“ in der Tabelle „Cer pro Beispielseite“ gelangen Sie automatisch zum Fenster „Erweiterte Statistik“ und sehen sich die Genauigkeitsmessungen genauer an.